微軟(MSFT.US)新一代自研AI芯片“Maia 200”出鞘! 推理狂潮席捲全球 屬於AI ASIC的黃金時代到來

時間:2026-01-27 08:24:47

微軟

谷歌A

智通財經APP獲悉,美國科技巨頭微軟公司(MSFT.US)在美東時間週一重磅推出其升級換代後的第二代人工智能芯片(AI芯片),這是該科技巨頭推動以更高能效比與性價比算力路徑爲其雲端AI訓練/推理算力資源服務提供的至關重要自研AI算力集羣硬件,併爲售價昂貴的英偉達AI GPU系列人工智能算力集羣提供替代型AI算力基礎設施解決方案的核心舉措。

這款由“全球芯片代工之王”臺積電所製造的名爲“Maia 200”的微軟自研AI芯片(與谷歌TPU架構類似,走的是AI ASIC技術路線),正陸續進入微軟位於愛荷華州的大型AI數據中心,下一步的大規模部署將轉向鳳凰城地區的某個大型數據中心。微軟在當地時間週一邀請開發者們積極使用圍繞Maia的專屬控制軟件,但目前尚不清楚微軟Azure雲計算服務平臺的龐大用戶們何時能夠精準調用/使用搭載該AI芯片的雲端AI服務器算力集羣。

毋庸置疑的是,席捲全球的生成式AI熱潮加快了雲計算與芯片設計巨頭們的AI ASIC路線雲平臺內部專屬AI芯片開發進程,它們正爭相爲先進的大型AI數據中心設計出速度最快且能效最爲強勁的高性價比AI算力基礎設施集羣。美國芯片設計巨頭邁威爾(MRVL.US)及其最大競爭對手博通公司(AVGO.US),以及來自中國臺灣的聯發科,愈發轉向聚焦於攜手亞馬遜、谷歌等雲計算巨頭們共同打造出根據其AI數據中心具體需求量身定製的AI ASIC算力集羣,而這項ASIC業務已經成長爲這三家專注設計的芯片巨頭一項非常重要業務,比如博通聯手谷歌所打造的TPU AI算力集羣就是一種最典型的AI ASIC技術路線。

雲計算三巨頭中的最強AI ASIC! 拳打亞馬遜Trainium,腳踢谷歌TPU

繼谷歌與亞馬遜近期紛紛發佈新一代性能大幅升級的雲計算平臺內部專屬AI ASIC芯片之後,同爲全球雲計算“三巨頭”的微軟傳聞已久的Maia 200 新一代高性能AI芯片產品終於問世。

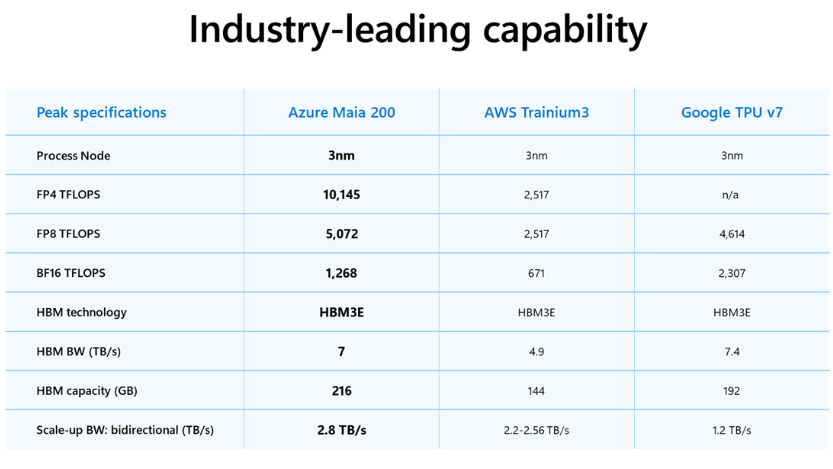

微軟在一份公告中表示,這款“爲天量級AI推理任務而生”的AI芯片在多項測試中超越亞馬遜最新推出的第三代Trainium以及谷歌前不久所推出的第七代TPU。因此,微軟官方將剛剛重磅推出的Maia 200稱爲“所有超大規模雲計算服務商中性能最強的自研內部專屬AI芯片”。

微軟雲計算與人工智能負責人斯科特·古思裏(Scott Guthrie)在一篇博客文章中表示,由臺積電代工的首批AI芯片設備將提供給微軟的超級智能團隊,用於大規模生成數據與執行龐大AI訓練工作負載以改進微軟的下一代AI大模型。該AI芯片也將用於爲企業版Copilot AI助手系列產品以及微軟內部的託管型AI推理服務系列產品提供雲端AI算力基礎設施集羣支撐,其中也包括微軟向雲計算客戶們出租的OpenAI最新GPT系列AI大模型。

雖然微軟的自研AI芯片推進計劃啓動時間,晚於另外兩大全球雲計算領軍者——亞馬遜AWS以及Alphabet旗下谷歌雲計算平臺GCP開啓雲平臺內部專屬自研AI芯片的正式部署時間,但是這三家雲計算超級巨頭可謂有着相似的目標:打造最具備成本效益、能夠無縫接入龐大數據中心的雲計算機器,併爲雲計算客戶們帶來顯著的成本節約與其他關鍵層面的能效大幅提升。此外,英偉達最新推出且行業領先AI芯片算力集羣的極高成本與持續供給短缺,推動了雲計算市場爭相尋找更加廉價且頗具能效比的替代算力來源。

微軟表示,這款新推出的雲計算專屬AI芯片在大部分AI推理任務上的性能優於谷歌和亞馬遜雲計算服務的同類半導體設備。“Maia 200 也是微軟迄今部署過的最高效人工智能推理系統。”古思裏表示,他所指的推理工作負載是使用AI大模型生成對查詢的迴應類似AI推理進程。

據瞭解,Maia 200每美元性能比微軟當前最新一代硬件提升30%,該AI芯片在FP4精度下的整體推理性能是第三代亞馬遜TrainiumAI ASIC雲計算內部專屬自研AI芯片的足足三倍,FP8性能則超過谷歌第七代TPU。微軟已向軟件開發者、學術界和前沿AI實驗室開放Maia 200軟件開發工具包的預覽版,並計劃“未來一段時間向更多客戶開放”該AI芯片的雲端服務器租用。

據斯科特·古思裏在微軟官方博客中的介紹內容,Maia 200採用臺積電最尖端的3nm先進製程工藝所製造,每顆芯片包含超過1400億個晶體管。該AI芯片專爲大規模AI推理工作負載定製,在4位精度(FP4)下可提供超過10 petaFLOPS的算力,在8位精度(FP8)下提供超過5 petaFLOPS的性能,所有這些性能都在750瓦的芯片功耗範圍內實現。

除了芯片本身的算力外,微軟也在存儲系統參數上大舉加碼。該公司披露,Maia 200配備216GB、帶寬達7TB/s的HBM3e,以及272MB的片上SRAM。在系統拓展層面,每塊芯片提供2.8TB/s的雙向專用擴展帶寬,支持在6144個加速器集羣中提供可預測的高性能集合操作。這些強勁的參數以及本身強大算力,解釋了爲何Maia 200推理性能跑分大幅跑贏亞馬遜第三代Trainium與谷歌第七代TPU。

此外,微軟在博客中表示,該科技巨頭已經在着手設計該AI芯片的繼任者——名爲Maia 300的下一代AI芯片。如果內部研發進展受挫,微軟也還有其他選擇:作爲與最緊密合作夥伴OpenAI此前達成重磅協議的一部分,微軟可以獲取這家ChatGPT開發商處於萌芽階段的獨家自研AI芯片設計方案。

來自市場研究機構Gartner的資深分析師奇拉格·德卡特(Chirag Dekate)表示,Maia 200的重磅發佈顯示微軟對其造芯工程是非常認真的。他強調,大型AI數據中心不斷增長的能耗需求,以及全球許多地區缺乏新的電力來源,使得像Maia這樣以性價比和高效率爲核心的AI算力項目更加關鍵。“如果你只是做一兩次噱頭式活動,你不會進行這種大規模投資,”德卡特表示。“這是一項跨多代的且戰略性的投資。”

屬於AI ASIC技術路線的盛世已經到來

毫無疑問的是,經濟性與電力層面的重大約束,迫使微軟、亞馬遜、谷歌以及Facebook母公司Meta都在推AI ASIC技術路線的雲計算內部系統自研AI芯片,核心目的都是爲了AI算力集羣更具性價比與能效比。

類似“星際之門”的超大規模AI數據中心建設成本高昂,因此科技巨頭們愈發要求AI算力系統趨於經濟性,以及電力約束之下,科技巨頭力爭把“單位Token成本、單位瓦特產出”做到極致,屬於AI ASIC技術路線的繁榮盛世可謂已經到來。

此外,類似英偉達Blackwell架構先進AI GPU算力集羣的長期供不應求、成本高昂且受制於供應鏈瓶頸與交付節奏,自研AI ASIC無疑能提供“第二曲線產能”,並在採購談判、產品定價與雲計算服務毛利層面更主動,疊加谷歌、微軟等雲計算大廠們能把“芯片—互聯—系統—編譯器/運行時—調度—觀測/可靠性”一體化共設計,提高算力基礎設施利用率並降低TCO。

微軟把 Maia 200的定位直接寫成“顯著改善AI token generation的經濟性”,並多次強調performance per dollar;AWS 也把 Trainium3 的目標寫成“best token economics”,並用能效/性價比作爲賣點;谷歌雲計算平臺則將Ironwood定義爲“人工智能推理時代”的專用 TPU(TPU也屬於AI ASIC技術路線),強調能效與大規模推理服務。

隨着DeepSeek徹底掀起AI訓練與推理層面的“效率革命”,推動未來AI大模型開發向“低成本”與“高性能”兩大核心聚焦,相比於英偉達AI GPU路線更具性價比優勢的AI ASIC在雲端AI推理算力需求猛增的背景之下,邁入比2023-2025年期間AI熱潮時期更加強勁的需求擴張軌跡,未來谷歌、OpenAI以及Meta等大客戶有望持續斥巨資攜手博通開發AI ASIC芯片。

根據Semianalysis測算數據,谷歌最新的TPU v7 (Ironwood) 展現出了驚人的代際跨越,TPU v7的BF16算力高達4614 TFLOPS,而上一代被廣泛使用的TPU v5p僅爲459 TFLOPS,這堪稱是整整一個數量級的提升。此外,TPU v7顯存直接對標英偉達Blackwell架構的 B200,針對特定應用,架構上更具性價比與能效比優勢的AI ASIC可以更容易地吃下主流推理端算力負載,比如谷歌最新TPU集羣甚至能提供比英偉達Blackwell高出1.4倍的每美元性能。

英偉達AI GPU幾乎壟斷的AI訓練側需要更加強大的AI算力集羣通用性以及整個算力體系的快速迭代能力,而AI推理側則在前沿AI技術規模化落地後更看重單位token成本、延遲與能效。谷歌明確把Ironwood定位爲“爲AI推理時代而生”的TPU代際,並強調性能/能效/算力集羣性價比與可擴展性。

谷歌在11月下旬重磅推出Gemini3 AI應用生態之後,這一最前沿AI應用軟件隨即風靡全球,推動谷歌AI算力需求瞬間激增。Gemini3 系列產品一經發布即帶來無比龐大的AI token處理量,迫使谷歌大幅調低Gemini 3 Pro與Nano Banana Pro的免費訪問量,對Pro訂閱用戶也實施暫時限制,疊加韓國近期貿易出口數據顯示SK海力士與三星電子HBM存儲系統以及企業級SSD需求持續強勁,進一步驗證了華爾街所高呼的“AI熱潮仍然處於算力基礎設施供不應求的早期建設階段”。

英偉達前不久與AI芯片初創公司Groq達成的200億美元非獨家授權合作協議,將其AI推理技術授權給英偉達,並且在交易完成後Groq創始人及核心研發團隊將加入英偉達,可謂共同凸顯出隨着“全球AI推理大浪潮”全面來襲,疊加谷歌TPU AI算力集羣帶來的越來越大競爭壓力,英偉達力爭通過“多架構AI算力+鞏固CUDA生態+引進更多AI芯片設計人才”來維持其在AI芯片領域高達90%市場份額的絕對主導權。

摩根士丹利近日發佈的一份研報顯示,谷歌TPU AI芯片的實際產量在2027年和2028年將分別達到500萬和700萬塊,較該金融巨頭此前給出的預期可謂分別大舉上修67%、120%。而這一產量激增預期可能預示着谷歌將開啓TPU AI芯片的直接對外銷售。更具基本面衝擊力的是,大摩的這份研究報告測算每50萬片TPU外銷,便有望爲谷歌帶來130億美元的額外營收以及高達0.40美元的每股收益。

免責聲明:本資訊不構成建議或操作邀約,市場有風險,投資需謹慎!